در این مقاله به بررسی یک فایل مهم در وب سایت ها به نام فایل robots.txt می پردازیم. این فایل که وجود آن در هر وب سایت اختیاری است نقش مهمی در مدیریت ربات هایی که به وب سایت شما سرک می کشند دارد.

فایل Robots.txt یک فایل متنی است که در هاست قرار میگیرد و به موتورهای جستجو و برنامههای رباتیکی میگوید که کدام بخشهای وبسایت میتوانند در جستجوی آنها شرکت کنند و کدام بخشها را نباید اسکن کنند. این فایل به بهینهسازی سئو کمک میکند تا موتورهای جستجو محتوا را بهتر فهمیده و صفحات مناسبتری را نمایش دهند.

در ادامه به بررسی تفصیلی فایل robots.txt و خط کدهای مهم آن، دلایل اهمیت این فایل، نحوه ساخت، تست و مکان قرارگیری آن می پردازیم.

همچنین ما سعی کردیم برای سایت های فروشگاهی یک فایل مناسب robots.txt و برای دیگر انواع سایت ها هم یک فایل جداگانه robots.txt را ارائه دهیم.

آنچه در این مقاله می خوانید :

فایل robots.txt چیست؟

هر روزه بازدیدهای متعددی از وب سایت شما صورت می گیرد که همه آن ها توسط انسان نیستند، این بازدیدها توسط ربات و یا اسپایدارهایی هستند که به وسیله موتورهای جستجو مانند گوگل، یاهو و بینگ به سایت شما ارسال می شوند تا محتوای شما را فهرست بندی کنند و در نتایج جستجو نمایش دهند.

در این میان موقعیت هایی وجود دارد که ممکن است نخواهید ربات ها در اطراف وب سایت شما بچرخند و همه چیز را ایندکس کند، اینجاست که فایل robots.txt وارد کار می شود.

با اضافه کردن دستورالعملهای مخصوصی به فایل robots.txt، می توانید رباتها را هدایت کنید تا فقط صفحاتی را که می خواهید بخزند و ایندکس کنند.

به طور کلی، استفاده از فایل Robots.txt به وبمسترها امکان کنترل دقیق تری بر روی نحوه دسترسی رباتها به محتواهای وبسایتشان را میدهد و به بهبود عملکرد و سئو وبسایت کمک میکند.

دلایل استفاده از فایل robots.txt

- با استفاده از این فایل به مدیریت اضافه بار سرور وب سایت خود کمک می کنید. با محدود کردن دسترسی رباتها به بخشهای غیرضروری وبسایت، میتوانید بار سرور را کاهش دهید و منابع سرور را بهینهتر استفاده کنید.

- از هدر رفتن زمان رباتهایی که از صفحات وب سایت شما بازدید می کنند و شما نمیخواهید این اتفاق بیفتد، جلوگیری کنید و در عوض آن ها را به سایر قسمت ای وب سایت خود هدایت کنید.

کنترل دسترسی رباتها با استفاده از Robots.txt . میتوانید به موتورهای جستجو و رباتهای وب مشخص کنید که کدام بخشهای وبسایت قابل دسترسی هستند و کدام بخشها را نباید اسکن کنند. این کنترل دسترسی به موتورهای جستجو کمک میکند تا منابع و زمان خود را بهینه کنند و اطلاعات مهمتر را جستجو کنند. - با استفاده از txt می توانید پوشه ها یا زیر دامنه های خاصی را به صورت خصوصی نگه دارید. اگر محتوای حساسی در وبسایت دارید که نمیخواهید به عموم دسترسی داشته باشد، میتوانید این محتوا را از اسکن توسط موتورهای جستجو به موجودیتهای غیرمجاز محافظت کنید.

- استفاده صحیح از فایل Robots.txt به وبمسترها کمک میکند تا با استانداردهای موتورهای جستجو سازگاری داشته باشند و در نتیجه، ارتباط بهتری با موتورهای جستجو برقرار کنند.

استفاده از فایل robots.txt اجباری است؟

فایل robots.txt یک فایل اجباری برای وب سایت ها نیست زیرا در حالتی که این فایل وجود نداشته باشد هم اگر یک ربات به وب سایت شما بیاید و این فایل را نبیند، می تواند وب سایت شما را بخزد و صفحات را فهرست بندی کند.

فایل robots.txt تنها زمانی مورد نیاز است که بخواهید کنترل بیشتری بر آنچه ربات ها در سایت شما انجام می دهند داشته باشید.

استفاده از این فایل به وبمسترها اجازه میدهد که به موتورهای جستجو دستورالعملهایی در مورد دسترسی به محتواهای وبسایتشان ارائه دهند. این میتواند در بهینهسازی سئو و کنترل برخورد رباتها با محتواهای مختلف وبسایت مفید باشد.

اگر وبسایت شما محتوایی دارد که نمیخواهید موتورهای جستجو آن را اسکن کنند یا اگر قصد دارید برخی از صفحات را از نمایش در نتایج جستجو منع کنید، استفاده از فایل Robots.txt میتواند کمک کننده باشد.

به همین ترتیب، اگر نیازی به محدود کردن دسترسی رباتها به بخشهای خاصی از وبسایت ندارید، ممکن است این فایل برای شما لزومی نداشته باشد. به طور خلاصه، استفاده از فایل Robots.txt اختیاری است و بسته به نیازها و اهداف وبسایت، میتوانید تصمیم بگیرید که آیا از آن استفاده کنید یا خیر.

آیا ربات ها به robots.txt پایبند هستند؟

بله، بیشتر موتورهای جستجو و رباتهای وب به دستورات موجود در فایل Robots.txt پایبندی میکنند. با این حال، مهم است توجه داشته باشید که رباتهای همهچیزخوان (به عنوان مثال، رباتهای مختص موتورهای جستجو معروف مانند Googlebot) بهطور عمومی این دستورات را رعایت میکنند.

اما رباتهای دیگری که این دستورات را رعایت نمیکنند، ممکن است به طور مستقیم به صفحاتی دسترسی پیدا کنند که در فایل Robots.txt منع شدهاند.

از این رو، فایل Robots.txt بیشتر به عنوان یک راهنمایی برای رباتها عمل میکند تا یک محدودیت مطلق. برای موارد محرمانگی یا حساس، بهتر است از روشهای دیگری مانند استفاده از پسورد یا احراز هویت استفاده کنید.

البته برخی سئوکار ها معتقد هستند که همه ربات ها به قوانینی که در فایل robots.txt وجود دارد پایبند نیستند.برای مثال اگر محتوایی که می خواهید از نمایش آن در نتایج جستجو جلوگیری کنید، با لینک خارجی به آن اشاره شده باشد، موتورهای جستجو حتما آن را فهرست می کنند.

(البته می توانید محتوایی که نمی خواهید سئو شود را کلاً از تنظیمات سئو آن محتوا no index نمایید. در اینجا بحث در مورد فایل robots.txt است)

تنها راه برای اطمینان از ایندکس نشدن محتوای شما این است که یک متا تگ noindex به صفحه مربوطه اضافه کنید. خط کد گفته شده در زیر آمده است این خط کد در قسمت html صفحه شما قرار می گیرد.

البته این به این معنی نیست که از ایجاد فایل Robots.txt صرف نظر کرده و بی خیال شوید. حتماً موثر است. طی بررسی همه سایت های بزرگ و مهم نیز از این فایل استفاده می کنند.

محل قرارگیری فایل robots.txt کجاست؟

فایل robots.txt همیشه در دامنه ریشه یک وب سایت قرار می گیرد. به عنوان مثال، مکان فایل robots.txt در سایت example در آدرس https://www.example.com/robots.txt می باشد.

برای پیدا کردن فایل robots.txt در اکثر وب سایت ها باید با FTP به آن دسترسی پیدا کنید و یا با دسترسی به مدیر فایل در CPanel میزبان خود، آن را ویرایش کنید.

در برخی از پلتفرمهای CMS می توانید فایل را در ناحیه مدیریتی یا پیشخوان وب سایت پیدا کنید. اگر از وردپرس استفاده می کنید، فایل robots.txt در پوشه public_html وب سایت شما قابل دسترسی است.

فایل robots.txt نیاز به ایجاد دارد ، در برخی افزونه های سئو گزینه ای برای ایجاد آن وجود دارد و در برخی لازم است که در هاست در پوشه public_html ایجاد شود.

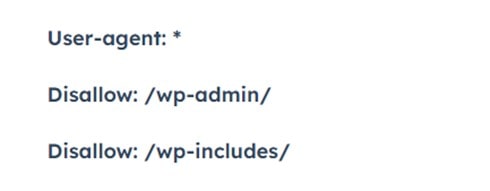

وردپرس به طور پیش فرض شامل یک فایل robots.txt با پیکربندی زیر است:

خط کدهای بالا به ربات ها میگوید که در تمام قسمت های وب سایت به جز هر چیزی که در پوشه های /wp-admin/ یا /wp-includes/ قرار دارد بخزند.

دلایل اهمیت فایل robots.txt

ممکن است دلایل زیادی وجود داشته باشد که بخواهید فایل robots.txt خود را سفارشی کنید برای مثال از کنترل بودجه خزیدن ربات ها گرفته تا مسدود کردن بخش هایی از یک وب سایت از خزیدن شدن توسط بات ها و ایندکس شدن آن ها.

در این بخش چند دلیل اهمیت استفاده از فایل robots.txt را بررسی می کنیم.

مسدود کردن خزنده ها

مسدود کردن خزنده ها هنگامی که وب سایت شما فعال است کار درستی نیست اما زمانی که در حال توسعه یک وب سایت هستید می تواند کمک کننده باشد.

هنگامی که اسپایدرها را مسدود می کنید، به جلوگیری از نمایش صفحات خود در موتورهای جستجو کمک می کنید، و این موضوع زمانی که هنوز صفحات شما برای مشاهده آماده نباشند، خوب است.

مخفی کردن برخی از صفحات

یکی از رایج ترین دلایل استفاده از فایل robots.txt، محدود کردن دسترسی ربات های موتور جستجو به بخش هایی از وب سایت است.

این کار امر می تواند به، به حداکثر رساندن بودجه خزیدن وب سایت شما کمک کند و از تجمع صفحات ناخواسته در نتایج جستجو جلوگیری کند.

- مخفی کردن منو های غیر ضروری از مدیریت وردپرس

- آموزش مخفی کردن فایل wp-config.php در وردپرس

- مخفی کردن نسخه وردپرس

محتویات فایل robots.txt

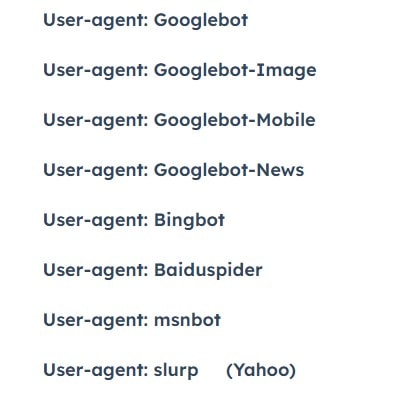

فایل robots.txt از بلوک هایی از خطوط دستورالعمل تشکیل شده است که هر دستورالعمل با یک user-agent (موتور جستجو) شروع می شود و سپس قوانین مربوط به آن user-agent در زیر آن قرار می گیرد.

هنگامی که ربات های مربوط به یک موتور جستجوی خاص وارد وب سایت شما می شوند، به دنبال user-agent ای می گردند که برای آن ها نوشته شده است. برای تشریح این موضوع به بخش های زیر دقت کنید.

User-Agent

دستور user-agent به شما امکان می دهد ربات ها یا اسپایدرهای خاصی را مورد هدف قرار دهید. برای مثال، اگر فقط می خواهید بینگ یا گوگل را هدف قرار دهید، از دستورالعمل های زیر استفاده کنید.

دقت کنید که کوچکی و بزرگی حروف کدها اهمیت دارد.

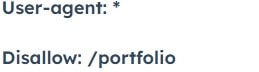

Disallow

دستورالعمل Disallow به موتورهای جستجو می گوید که از خزیدن یا دسترسی به برخی صفحات یا فهرستهای وب سایت خودداری کنند. در ادامه چندین نمونه از نحوه استفاده از دستورالعمل Disallow آمده است.

در این مثال به همه رباتها دستور می دهیم که هیچ چیزی را در پوشه /portfolio در وب سایت ما نخزند.

اما اگر فقط میخواهیم Bing آن دایرکتوری را نخزد، این کد به این شکل تغییر می کند:

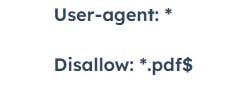

مسدود کردن فایل pdf یا نوع خاصی از فایل

اگر نمی خواهید پی دی اف ها یا سایر انواع فایل شما خزیده شود، دستورالعمل زیر به این موضوع کمک خواهد کرد. علامت $ در پایان کد زیر به موتور جستجو می گوید که انتهای URL به چه کلمه ای ختم می شود.

بنابراین اگر یک فایل pdf در mywebsite.com/site/myimportantinfo.pdf داشته باشیم، موتورهای جستجو به آن دسترسی نخواهند داشت.

dfds

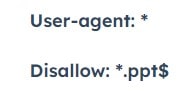

همین کد برای فایل های پاورپوینت به شکل زیر خواهد بود:

البته بهترین گزینه در این شرایط این است که یک پوشه برای فایل های PDF یا سایر فایل های خود ایجاد کنید و سپس به خزنده ها اجازه خزیدن در آن و ایندکس کردن کل دایرکتوری را با استفاده از یک متا تگ ندهید.

نحوه مسدود کردن دسترسی به کل وب سایت

برای مسدود کردن دسترسی به کل وبسایت با استفاده از فایل Robots.txt ، شما باید یک دستور اختصاصی به نام `Disallow` را برای ریشه وبسایتتان ارائه دهید. این دستور به رباتها میگوید که هیچ صفحهای از وبسایت شما قابل اسکن نیست.

در واقع، شما میتوانید به رباتها اطلاع دهید که به هیچ بخشی از وبسایت شما دسترسی ندارند.

دستور زیر در فایل Robots.txt این کار را انجام میدهد:

User-agent: * Disallow: /

در این دستور:

User-agent: *: این بخش به تمام رباتها اجازه میدهد که از این دستورات استفاده کنند.Disallow: /: این دستور به رباتها میگوید که به هیچ بخشی از وبسایت دسترسی ندارند، به عبارت دیگر هیچ صفحهای از وبسایت اسکن نشود.

(ستاره) ای که در کد بالا مشاهده می کنید، همان چیزی است که ما آن را عبارت “wildcard” می نامیم. هنگامی که از یک ستاره استفاده می کنیم، به این مفهوم اشاره می کنیم که قوانین زیر باید برای همه user-agentها اعمال شود.

لطفاً توجه داشته باشید که این دستور به این معناست که تمام رباتها از دسترسی به وبسایت منع میشوند. این میتواند برای مواقعی که نیاز به مسدود کردن تمام دسترسیها به وبسایت دارید (مثلاً در مواقع تعمیرات یا تغییرات بزرگ) مفید باشد.

اگر نیاز به مسدود کردن بخشهای خاصی از وبسایت دارید، میتوانید دستورات `Disallow` مربوط به هر بخش را بهصورت مجزا اضافه کنید.

Allow

استفاده از دستورالعمل Allow به شما کمک می کند صفحات یا دایرکتوریهای خاصی را که میخواهید رباتها به آنها دسترسی داشته باشند و آن ها را بخزند مشخص کنید.

در مثال زیر به Googlebot میگوییم که نمیخواهیم دایرکتوری نمونه کارها خزیده شود، اما میخواهیم به یک مورد خاص نمونه کارها دسترسی پیدا کرده و آن را بخزد:

User-agent: Googlebot Disallow: /portfolio Allow: /portfolio/crawlableportfolio

نقشه سایت

قرار گرفتن مکان نقشه سایت در فایل robots.txt می تواند کار خزنده های موتورهای جستجو را آسان تر کند تا نقشه سایت شما را بخزند. اگر نقشه های سایت خود را مستقیماً به ابزارهای وب مستر هر موتور جستجو ارسال می کنید، لازم نیست آن را به فایل robots.txt خود اضافه کنید.

به طور مثال، اگر نقشهی سایت شما در مسیر https://example.com/sitemap_index.xml قرار دارد، میتوانید این خط را به فایل robots.txt اضافه کنید:

Sitemap: https://example.com/sitemap_index.xml

این خط به موتورهای جستجو اطلاع میدهد که نقشهی سایت شما در آدرس مشخصشده وجود دارد و آنها باید به آن مراجعه کنند.

لطفاً توجه داشته باشید که مهمتر این است که نقشهی سایت خود را در Google Search Console (برای گوگل) و ابزارهای مشابه موتورهای جستجوی دیگر ثبت کرده باشید تا به بهترین شکل تاثیرگذاری داشته باشد.

تاخیر در خزیدن (Crawl Delay)

تاخیر در خزیدن که با کد Crawl-Delay مشخص می شود می تواند به یک ربات بگوید که هنگام خزیدن وب سایت شما، سرعت خود را کاهش دهد تا سرور شما هنگ نکند.

این کد، دستورالعملی است که باید مراقب آن باشید. در یک وب سایت بسیار بزرگ، این دستورالعمل میتواند تعداد URL هایی را که در هر روز خزیده می شوند را تا حد زیادی به حداقل برساند، و نتیجه معکوس به بار بیاورد.

به عبارت دیگر ، “Crawl Delay” یک دستور خاص در فایل robots.txt است که به موتورهای جستجو میگوید چه مقدار تاخیر بین درخواستهای متوالی از وبسایت شما باید باشد.

این مقدار به واحد ثانیه تعیین میشود و به موتورها کمک میکند تا نرخ درخواستها را تنظیم کنند تا بر بار سرور شما اثر منفی نگذارند. برای مثال، اگر میخواهید موتورهای جستجو تاخیر 5 ثانیه را در درخواستهای بین صفحات وبسایتتان رعایت کنند، میتوانید این خط را به فایل robots.txt اضافه کنید:

User-agent: * Crawl-delay: 5

نکته: Crawl-Delay توسط Google یا Baidu پشتیبانی نمی شود. اگر می خواهید از خزندههای آنها بخواهید خزیدن وب سایت شما را کند کنند، باید این کار را از طریق ابزارهای آنها انجام دهید.

نکته دیگر: در استفاده از این دستور حساس باشید و قبل از استفاده از یک سئوکار در رابطه با سایت خود مشورت بگیرید.

علائم مورد استفاده در robots.txt

علائم مورد استفاده در کد فایل robots.txt هر کدام پیامی را منتقل می کنند که به آن ها می پردازیم.

- ستاره: * به عنوان یک علامت عام در نظر گرفته می شود و می تواند هر دنباله ای از کاراکترها را نشان دهد

- علامت دلار: $ برای تعیین انتهای URL استفاده می شود.

یک مثال خوب برای استفاده از علامت * در سناریویی است که میخواهید موتورهای جستجو را از خزیدن صفحاتی که ممکن است علامت سوال در آنها وجود دارد جلوگیری کنید. کد زیر به همه ربات ها می گوید که از خزیدن URL هایی که دارای علامت سوال هستند صرف نظر کنند.

User-agent: * Disallow: /*?

به عبارت دیگر، این دستور به موتورهای جستجو اجازه نمیدهد تا به صفحاتی دسترسی پیدا کنند که دارای پارامترهای پرسوجو در آدرسهای آنها وجود دارد.

این ممکن است مفید باشد برای جلوگیری از اینکه موتورهای جستجو صفحاتی را با پارامترهای مختلف اسکن کنند و موجب ایجاد محتوای تکراری شوند.

به عنوان مثال، فرض کنید صفحاتی دارای پارامترهای مختلف مانند ?page=1, ?page=2, و غیره، دارید. با اضافه کردن Disallow: /*? به robots.txt، شما به موتورهای جستجو اجازه نمیدهید این نسخههای مختلف صفحه را اسکن کنند و به عبارتی، از تکرار محتوا جلوگیری میکنید.

چگونه یک فایل Robots.txt را ایجاد یا ویرایش کنیم؟

اگر فایل robots.txt در سایت شما وجود ندارد می توانید با روش زیر آن را ایجاد کنید.

- ویرایشگر متن دلخواه خود را برای شروع یک سند جدید باز کنید. ویرایشگرهای رایجی که ممکن است در رایانه شما وجود داشته باشد عبارتند از Notepad، TextEdit یا Microsoft Word.

- دستورالعمل هایی را که می خواهید داشته باشید را به سند خود اضافه کنید.

- فایل را با نام “txt” ذخیره کنید.

- فایل خود را همانطور که در قسمت بعد نشان داده شده است تست کنید.

- با استفاده از FTP یا استفاده از Cpanel فایل را در سرور خود آپلود کنید؛ دقت کنید که نحوه آپلود فایل به نوع وب سایت شما بستگی دارد.

در وردپرس می توانید از افزونه هایی مانند Yoast، All In One SEO، Rank Math برای تولید و ویرایش فایل خود استفاده کنید.

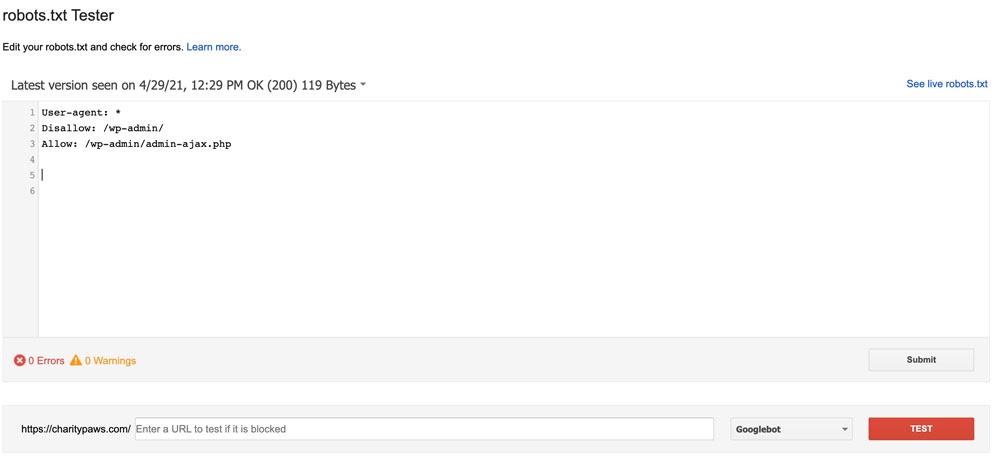

نحوه تست کردن فایل robots.txt

قبل از اینکه از فایل robots.txt که ایجاد کردهاید استفاده کنید باید آن را از طریق یک تستر اجرا کنید تا از معتبر بودن آن اطمینان حاصل کنید. این کار به جلوگیری از مشکلات مربوط به دستورالعمل های نادرست که ممکن است اضافه شده باشد کمک می کند.

ابزار تست robots.txt فقط در نسخه قدیمی کنسول جستجوی گوگل موجود است. اگر وب سایت شما به کنسول جستجوی گوگل متصل نیست، ابتدا باید این کار را انجام دهید.

از صفحه پشتیبانی Google دیدن کنید، سپس روی دکمه “open robots.txt tester” کلیک کنید. ویژگی مورد نظر برای آزمایش را انتخاب کنید تا به صفحه زیر هدایت شوید.

برای آزمایش کد robots.txt، کافی است آنچه را که در کادر موجود است حذف کنید و کد جدید خود را جایگزین کنید و روی «test» کلیک کنید. اگر پاسخ به تست شما “allowed” باشد، کد شما معتبر است و می توانید فایل واقعی خود را با کد جدید خود اصلاح کنید.

سایت های زیر هم بر تست فایل robots.txt مناسب هستند. (با کلیک بر روی آنها وارد بخش تست می شوید)

فایل آماده robots برای سایت های فروشگاهی و شرکتی و چندمنظوره و …

توضیحات کامل در مورد چگونگی ایجاد یک فایل robots ارائه شد ، اما در ادامه فایل آماده robots برای سایت های فروشگاهی و شرکتی و چندمنظوره و … را قرار می دهیم.

نکته : توجه داشته باشید که این فایل پیشفرض است و باید در صورت تمایل آن را سفارشی سازی نمایید.

فایل آماده robots برای سایت فروشگاهی

کد را می توانید از بخش زیر کپی نمایید. ممکن است لازم باشد بسته به نوع سایت خود آن را ویرایش نمایید.

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Disallow: /search/ Disallow: *?s=* Disallow: *?p=* Disallow: *&p=* Disallow: *&preview=* Disallow: /*feed Sitemap: https://Domain.com/sitemap_index.xml

- نقشه سایت را دقت داشته باشید ، باید آدرس نقشه سایت خود را قرار دهید

فایل آماده robots برای انواع دیگر سایت ها

کد را می توانید از بخش زیر کپی نمایید. لازم است بسته به نوع سایت خود آن را ویرایش نمایید.

User-Agent: * Disallow: /wp-admin/ Disallow: /readme.html Allow: /wp-admin/admin-ajax.php Sitemap: https://Domain.com/sitemap_index.xml

نکته پایانی

در پایان لازم است که مجدد ذکر شود این فایل به موتورهای جستجو کمک میکند تا بهترین شکل ممکن محتوا را اسکن کنند و از اسکن غیرمطلوبی که ممکن است منجر به تکرار محتوا، مصرف بیشازحد منابع سرور، یا دسترسی به صفحات حساس شود، جلوگیری کنند.

در مورد مشکل سئو که به واسطه هک شدن سایت که نتایج گوگل سایت چینی می شود، فایل robots.txt نقش مهمی دارد. وقتی که سایت شما هک میشود و محتوای غیرمجاز یا تغییر یافته به آن اضافه میشود، ممکن است محتوای مخرب به اسکن توسط موتورهای جستجو بپردازد و در نتیجه، مشکلات سئویی ایجاد شود.

به علاوه، اگر سایت شما هدف یک حمله هک شده است، توصیه میشود که علاوه بر تصحیح مشکل امنیتی، محتوای آلوده را از سایت پاک کنید، به سرعت اطلاعات خود را به تیم امنیتی اعلام کنید و از ابزارهای وبمستر استفاده کنید تا تغییرات نامطلوب در سایتتان را کشف و اقدامات لازم را انجام دهید.

در صورتی که سایت هک شده است ، استفاده از خدمات حل مشکل هک شدن سایت ، می تواند موثر باشد

از اینکه با ما همراه بودید ، از شما ممنونیم.

منبع مقاله : وبلاگ hubspot.com